Hello,

C’est avec énormément de retard que je réponds.

Je suis tombé sur ce post car je cherchais comment tester des disques NVME car je teste différentes installations de NVME, SSD et HDD sur mes serveurs.

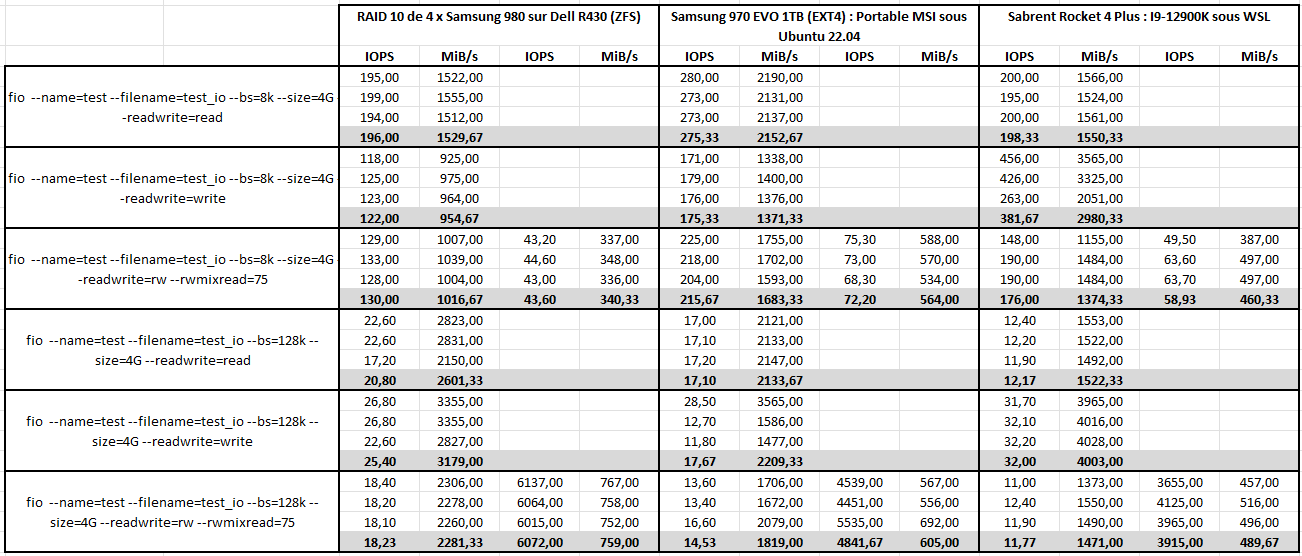

Voici les résultats du test réalisé sur un ZFS en RAID 10 de 4 x Samsung 980 réparties sur 2 cartes PCI NVME. Le tout sur un Dell R430.

Je ne possède que ce type de disques en NVME. Je peux également réaliser les tests sur un disque seul, Raid 0, Raid 1, jusqu’à 4 disques.

fio --name=test --filename=test_io --bs=8k --size=4G --readwrite=read

read: IOPS=197k, BW=1539MiB/s (1613MB/s)(4096MiB/2662msec)

read: IOPS=193k, BW=1509MiB/s (1583MB/s)(4096MiB/2714msec)

read: IOPS=195k, BW=1522MiB/s (1596MB/s)(4096MiB/2691msec)

read: IOPS=199k, BW=1555MiB/s (1631MB/s)(4096MiB/2634msec)

read: IOPS=194k, BW=1512MiB/s (1585MB/s)(4096MiB/2709msec)

fio --name=test --filename=test_io --bs=8k --size=4G --readwrite=write

write: IOPS=123k, BW=962MiB/s (1008MB/s)(4096MiB/4260msec); 0 zone resets

write: IOPS=124k, BW=968MiB/s (1015MB/s)(4096MiB/4231msec); 0 zone resets

write: IOPS=118k, BW=925MiB/s (970MB/s)(4096MiB/4426msec); 0 zone resets

write: IOPS=125k, BW=975MiB/s (1023MB/s)(4096MiB/4200msec); 0 zone resets

write: IOPS=123k, BW=964MiB/s (1011MB/s)(4096MiB/4249msec); 0 zone resets

fio --name=test --filename=test_io --bs=8k --size=4G --readwrite=rw --rwmixread=75

read: IOPS=126k, BW=987MiB/s (1034MB/s)(3068MiB/3110msec) | write: IOPS=42.3k, BW=331MiB/s (347MB/s)(1028MiB/3110msec); 0 zone resets

read: IOPS=109k, BW=854MiB/s (895MB/s)(3068MiB/3594msec) | write: IOPS=36.6k, BW=286MiB/s (300MB/s)(1028MiB/3594msec); 0 zone resets

read: IOPS=129k, BW=1007MiB/s (1055MB/s)(3068MiB/3048msec) | write: IOPS=43.2k, BW=337MiB/s (354MB/s)(1028MiB/3048msec); 0 zone resets

read: IOPS=133k, BW=1039MiB/s (1090MB/s)(3068MiB/2952msec) | write: IOPS=44.6k, BW=348MiB/s (365MB/s)(1028MiB/2952msec); 0 zone resets

read: IOPS=128k, BW=1004MiB/s (1052MB/s)(3068MiB/3057msec) | write: IOPS=43.0k, BW=336MiB/s (353MB/s)(1028MiB/3057msec); 0 zone resets

fio --name=test --filename=test_io --bs=128k --size=4G --readwrite=read

read: IOPS=22.9k, BW=2860MiB/s (2999MB/s)(4096MiB/1432msec)

read: IOPS=22.6k, BW=2829MiB/s (2966MB/s)(4096MiB/1448msec)

read: IOPS=22.6k, BW=2823MiB/s (2960MB/s)(4096MiB/1451msec)

read: IOPS=22.6k, BW=2831MiB/s (2968MB/s)(4096MiB/1447msec)

read: IOPS=17.2k, BW=2150MiB/s (2255MB/s)(4096MiB/1905msec)

fio --name=test --filename=test_io --bs=128k --size=4G --readwrite=write

write: IOPS=24.3k, BW=3039MiB/s (3186MB/s)(4096MiB/1348msec); 0 zone resets

write: IOPS=26.3k, BW=3285MiB/s (3444MB/s)(4096MiB/1247msec); 0 zone resets

write: IOPS=26.8k, BW=3355MiB/s (3518MB/s)(4096MiB/1221msec); 0 zone resets

write: IOPS=26.8k, BW=3355MiB/s (3518MB/s)(4096MiB/1221msec); 0 zone resets

write: IOPS=22.6k, BW=2827MiB/s (2964MB/s)(4096MiB/1449msec); 0 zone resets

fio --name=test --filename=test_io --bs=128k --size=4G --readwrite=rw --rwmixread=75

read: IOPS=17.1k, BW=2137MiB/s (2241MB/s)(3073MiB/1438msec) | write: IOPS=5689, BW=711MiB/s (746MB/s)(1023MiB/1438msec); 0 zone resets

read: IOPS=18.4k, BW=2306MiB/s (2418MB/s)(3073MiB/1333msec) | write: IOPS=6137, BW=767MiB/s (804MB/s)(1023MiB/1333msec); 0 zone resets

read: IOPS=18.2k, BW=2278MiB/s (2389MB/s)(3073MiB/1349msec) | write: IOPS=6064, BW=758MiB/s (795MB/s)(1023MiB/1349msec); 0 zone resets

read: IOPS=18.1k, BW=2260MiB/s (2370MB/s)(3073MiB/1360msec) | write: IOPS=6015, BW=752MiB/s (788MB/s)(1023MiB/1360msec); 0 zone resets

read: IOPS=17.0k, BW=2245MiB/s (2354MB/s)(3073MiB/1369msec) | write: IOPS=5975, BW=747MiB/s (783MB/s)(1023MiB/1369msec); 0 zone resets